最基本的結構就是兩種,一種是數組,一種是模擬指針(引用),所有的數據結構都可以用這兩個基本結構構造,HashMap也一樣。當程序試圖將多個 key-value 放入 HashMap 中時,以如下代碼片段為例:

HashMap<String,Object> m=new HashMap<String,Object>(); m.put("B", "李彥宏"); m.put("A", "馬云"); m.put("T", "馬化騰");

HashMap 采用一種所謂的“Hash 算法”來決定每個元素的存儲位置。當程序執行 map.put(String,Obect)方法 時,系統將調用String的 hashCode() 方法得到其 hashCode 值——每個 Java 對象都有 hashCode() 方法,都可通過該方法獲得它的 hashCode 值。得到這個對象的 hashCode 值之后,系統會根據該 hashCode 值來決定該元素的存儲位置。源碼如下:

public V put(K key, V value) { if (key == null) return putForNullKey(value); int hash = hash(key.hashCode()); int i = indexFor(hash, table.length); for (Entry<K,V> e = table[i]; e != null; e = e.next) { Object k; //判斷當前確定的索引位置是否存在相同hashcode和相同key的元素,如果存在相同的hashcode和相同的key的元素,那么新值覆蓋原來的舊值,并返回舊值。 //如果存在相同的hashcode,那么他們確定的索引位置就相同,這時判斷他們的key是否相同,如果不相同,這時就是產生了hash沖突。 //Hash沖突后,那么HashMap的單個bucket里存儲的不是一個 Entry,而是一個 Entry 鏈。 //系統只能必須按順序遍歷每個 Entry,直到找到想搜索的 Entry 為止——如果恰好要搜索的 Entry 位于該 Entry 鏈的最末端(該 Entry 是最早放入該 bucket 中), //那系統必須循環到最后才能找到該元素。 if (e.hash == hash && ((k = e.key) == key || key.equals(k))) { V oldValue = e.value; e.value = value; return oldValue; } } modCount++; addEntry(hash, key, value, i); return null; }

上面程序中用到了一個重要的內部接口:Map.Entry,每個 Map.Entry 其實就是一個 key-value 對。從上面程序中可以看出:當系統決定存儲 HashMap 中的 key-value 對時,完全沒有考慮 Entry 中的 value,僅僅只是根據 key 來計算并決定每個 Entry 的存儲位置。這也說明了前面的結論:我們完全可以把 Map 集合中的 value 當成 key 的附屬,當系統決定了 key 的存儲位置之后,value 隨之保存在那里即可.HashMap程序經過我改造,我故意的構造出了hash沖突現象,因為HashMap的初始大小16,但是我在hashmap里面放了超過16個元素,并且我屏蔽了它的resize()方法。不讓它去擴容。這時HashMap的底層數組Entry[]???table結構如下:?

?

?

Hashmap里面的bucket出現了單鏈表的形式,散列表要解決的一個問題就是散列值的沖突問題,通常是兩種方法:鏈表法和開放地址法。鏈表法就是將相同hash值的對象組織成一個鏈表放在hash值對應的槽位;開放地址法是通過一個探測算法,當某個槽位已經被占據的情況下繼續查找下一個可以使用的槽位。java.util.HashMap采用的鏈表法的方式,鏈表是單向鏈表。形成單鏈表的核心代碼如下:

void addEntry(int hash, K key, V value, int bucketIndex) { Entry<K,V> e = table[bucketIndex]; table[bucketIndex] = new Entry<K,V>(hash, key, value, e); if (size++ >= threshold) resize(2 * table.length);

上面方法的代碼很簡單,但其中包含了一個設計:系統總是將新添加的 Entry 對象放入 table 數組的 bucketIndex 索引處——如果 bucketIndex 索引處已經有了一個 Entry 對象,那新添加的 Entry 對象指向原有的 Entry 對象(產生一個 Entry 鏈),如果 bucketIndex 索引處沒有 Entry 對象,也就是上面程序代碼的 e 變量是 null,也就是新放入的 Entry 對象指向 null,也就是沒有產生 Entry 鏈。

?????? HashMap里面沒有出現hash沖突時,沒有形成單鏈表時,hashmap查找元素很快,get()方法能夠直接定位到元素,但是出現單鏈表后,單個bucket 里存儲的不是一個 Entry,而是一個 Entry 鏈,系統只能必須按順序遍歷每個 Entry,直到找到想搜索的 Entry 為止——如果恰好要搜索的 Entry 位于該 Entry 鏈的最末端(該 Entry 是最早放入該 bucket 中),那系統必須循環到最后才能找到該元素。

?????? 當創建 HashMap 時,有一個默認的負載因子(load factor),其默認值為 0.75,這是時間和空間成本上一種折衷:增大負載因子可以減少 Hash 表(就是那個 Entry 數組)所占用的內存空間,但會增加查詢數據的時間開銷,而查詢是最頻繁的的操作(HashMap 的 get() 與 put() 方法都要用到查詢);減小負載因子會提高數據查詢的性能,但會增加 Hash 表所占用的內存空間。

一、HashMap概述

HashMap基于哈希表的?Map?接口的實現。此實現提供所有可選的映射操作,并允許使用?null?值和?null?鍵。(除了不同步和允許使用?null?之外,HashMap?類與?Hashtable?大致相同。)此類不保證映射的順序,特別是它不保證該順序恒久不變。

值得注意的是HashMap不是線程安全的,如果想要線程安全的HashMap,可以通過Collections類的靜態方法synchronizedMap獲得線程安全的HashMap。

Map map = Collections.synchronizedMap(new HashMap()); 二、HashMap的數據結構

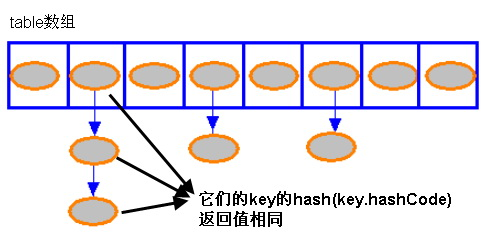

HashMap的底層主要是基于數組和鏈表來實現的,它之所以有相當快的查詢速度主要是因為它是通過計算散列碼來決定存儲的位置。HashMap中主要是通過key的hashCode來計算hash值的,只要hashCode相同,計算出來的hash值就一樣。如果存儲的對象對多了,就有可能不同的對象所算出來的hash值是相同的,這就出現了所謂的hash沖突。學過數據結構的同學都知道,解決hash沖突的方法有很多,HashMap底層是通過鏈表來解決hash沖突的。

圖中,紫色部分即代表哈希表,也稱為哈希數組,數組的每個元素都是一個單鏈表的頭節點,鏈表是用來解決沖突的,如果不同的key映射到了數組的同一位置處,就將其放入單鏈表中。

我們看看HashMap中Entry類的代碼:

/** Entry是單向鏈表。 * 它是 “HashMap鏈式存儲法”對應的鏈表。 *它實現了Map.Entry 接口,即實現getKey(), getValue(), setValue(V value), equals(Object o), hashCode()這些函數 **/ static class Entry<K,V> implements Map.Entry<K,V> { final K key; V value; // 指向下一個節點 Entry<K,V> next; final int hash; // 構造函數。 // 輸入參數包括"哈希值(h)", "鍵(k)", "值(v)", "下一節點(n)" Entry(int h, K k, V v, Entry<K,V> n) { value = v; next = n; key = k; hash = h; } public final K getKey() { return key; } public final V getValue() { return value; } public final V setValue(V newValue) { V oldValue = value; value = newValue; return oldValue; } // 判斷兩個Entry是否相等 // 若兩個Entry的“key”和“value”都相等,則返回true。 // 否則,返回false public final boolean equals(Object o) { if (!(o instanceof Map.Entry)) return false; Map.Entry e = (Map.Entry)o; Object k1 = getKey(); Object k2 = e.getKey(); if (k1 == k2 || (k1 != null && k1.equals(k2))) { Object v1 = getValue(); Object v2 = e.getValue(); if (v1 == v2 || (v1 != null && v1.equals(v2))) return true; } return false; } // 實現hashCode() public final int hashCode() { return (key==null ? 0 : key.hashCode()) ^ (value==null ? 0 : value.hashCode()); } public final String toString() { return getKey() + "=" + getValue(); } // 當向HashMap中添加元素時,繪調用recordAccess()。 // 這里不做任何處理 void recordAccess(HashMap<K,V> m) { } // 當從HashMap中刪除元素時,繪調用recordRemoval()。 // 這里不做任何處理 void recordRemoval(HashMap<K,V> m) { } }

HashMap其實就是一個Entry數組,Entry對象中包含了鍵和值,其中next也是一個Entry對象,它就是用來處理hash沖突的,形成一個鏈表。

?

三、HashMap源碼分析

?

先看看HashMap類中的一些關鍵屬性:

transient Entry[] table;//存儲元素的實體數組transient int size;//存放元素的個數int threshold; //臨界值 當實際大小超過臨界值時,會進行擴容threshold = 加載因子*容量final float loadFactor; //加載因子transient int modCount;//被修改的次數

其中loadFactor加載因子是表示Hsah表中元素的填滿的程度.

若:加載因子越大,填滿的元素越多,好處是,空間利用率高了,但:沖突的機會加大了.鏈表長度會越來越長,查找效率降低。

反之,加載因子越小,填滿的元素越少,好處是:沖突的機會減小了,但:空間浪費多了.表中的數據將過于稀疏(很多空間還沒用,就開始擴容了)

沖突的機會越大,則查找的成本越高.

因此,必須在?"沖突的機會"與"空間利用率"之間尋找一種平衡與折衷.?這種平衡與折衷本質上是數據結構中有名的"時-空"矛盾的平衡與折衷.

如果機器內存足夠,并且想要提高查詢速度的話可以將加載因子設置小一點;相反如果機器內存緊張,并且對查詢速度沒有什么要求的話可以將加載因子設置大一點。不過一般我們都不用去設置它,讓它取默認值0.75就好了。

?

下面看看HashMap的幾個構造方法:

public HashMap(int initialCapacity, float loadFactor) {2 //確保數字合法3 if (initialCapacity < 0)4 throw new IllegalArgumentException("Illegal initial capacity: " +5 initialCapacity);6 if (initialCapacity > MAXIMUM_CAPACITY)7 initialCapacity = MAXIMUM_CAPACITY;8 if (loadFactor <= 0 || Float.isNaN(loadFactor))9 throw new IllegalArgumentException("Illegal load factor: " + 10 loadFactor); 11 12 // Find a power of 2 >= initialCapacity 13 int capacity = 1; //初始容量 14 while (capacity < initialCapacity) //確保容量為2的n次冪,使capacity為大于initialCapacity的最小的2的n次冪 15 capacity <<= 1; 16 17 this.loadFactor = loadFactor; 18 threshold = (int)(capacity * loadFactor); 19 table = new Entry[capacity]; 20 init(); 21 } 22 23 public HashMap(int initialCapacity) { 24 this(initialCapacity, DEFAULT_LOAD_FACTOR); 25 } 26 27 public HashMap() { 28 this.loadFactor = DEFAULT_LOAD_FACTOR; 29 threshold = (int)(DEFAULT_INITIAL_CAPACITY * DEFAULT_LOAD_FACTOR); 30 table = new Entry[DEFAULT_INITIAL_CAPACITY]; 31 init(); 32 }

?

我們可以看到在構造HashMap的時候如果我們指定了加載因子和初始容量的話就調用第一個構造方法,否則的話就是用默認的。默認初始容量為16,默認加載因子為0.75。我們可以看到上面代碼中13-15行,這段代碼的作用是確保容量為2的n次冪,使capacity為大于initialCapacity的最小的2的n次冪,至于為什么要把容量設置為2的n次冪,我們等下再看。

?

重點分析下HashMap中用的最多的兩個方法put和get

下面看看HashMap存儲數據的過程是怎樣的,首先看看HashMap的put方法:

public V put(K key, V value) {// 若“key為null”,則將該鍵值對添加到table[0]中。if (key == null) return putForNullKey(value);// 若“key不為null”,則計算該key的哈希值,然后將其添加到該哈希值對應的鏈表中。int hash = hash(key.hashCode());//搜索指定hash值在對應table中的索引int i = indexFor(hash, table.length);// 循環遍歷Entry數組,若“該key”對應的鍵值對已經存在,則用新的value取代舊的value。然后退出!for (Entry<K,V> e = table[i]; e != null; e = e.next) { Object k;if (e.hash == hash && ((k = e.key) == key || key.equals(k))) { //如果key相同則覆蓋并返回舊值V oldValue = e.value;e.value = value;e.recordAccess(this);return oldValue;}}//修改次數+1modCount++;//將key-value添加到table[i]處 addEntry(hash, key, value, i);return null; }

上面程序中用到了一個重要的內部接口:Map.Entry,每個?Map.Entry?其實就是一個?key-value?對。從上面程序中可以看出:當系統決定存儲?HashMap?中的?key-value?對時,完全沒有考慮?Entry?中的?value,僅僅只是根據?key?來計算并決定每個?Entry?的存儲位置。這也說明了前面的結論:我們完全可以把?Map?集合中的?value?當成?key?的附屬,當系統決定了?key?的存儲位置之后,value?隨之保存在那里即可。

我們慢慢的來分析這個函數,第2和3行的作用就是處理key值為null的情況,我們看看putForNullKey(value)方法:

private V putForNullKey(V value) {for (Entry<K,V> e = table[0]; e != null; e = e.next) {if (e.key == null) { //如果有key為null的對象存在,則覆蓋掉V oldValue = e.value;e.value = value;e.recordAccess(this);return oldValue;}}modCount++;addEntry(0, null, value, 0); //如果鍵為null的話,則hash值為0return null;}

注意:如果key為null的話,hash值為0,對象存儲在數組中索引為0的位置。即table[0]

我們再回去看看put方法中第4行,它是通過key的hashCode值計算hash碼,下面是計算hash碼的函數:

//計算hash值的方法 通過鍵的hashCode來計算static int hash(int h) {// This function ensures that hashCodes that differ only by// constant multiples at each bit position have a bounded// number of collisions (approximately 8 at default load factor).h ^= (h >>> 20) ^ (h >>> 12);return h ^ (h >>> 7) ^ (h >>> 4);}

得到hash碼之后就會通過hash碼去計算出應該存儲在數組中的索引,計算索引的函數如下:

static int indexFor(int h, int length) { //根據hash值和數組長度算出索引值return h & (length-1); //這里不能隨便算取,用hash&(length-1)是有原因的,這樣可以確保算出來的索引是在數組大小范圍內,不會超出}

這個我們要重點說下,我們一般對哈希表的散列很自然地會想到用hash值對length取模(即除法散列法),Hashtable中也是這樣實現的,這種方法基本能保證元素在哈希表中散列的比較均勻,但取模會用到除法運算,效率很低,HashMap中則通過h&(length-1)的方法來代替取模,同樣實現了均勻的散列,但效率要高很多,這也是HashMap對Hashtable的一個改進。

?

? ??接下來,我們分析下為什么哈希表的容量一定要是2的整數次冪。首先,length為2的整數次冪的話,h&(length-1)就相當于對length取模,這樣便保證了散列的均勻,同時也提升了效率;其次,length為2的整數次冪的話,為偶數,這樣length-1為奇數,奇數的最后一位是1,這樣便保證了h&(length-1)的最后一位可能為0,也可能為1(這取決于h的值),即與后的結果可能為偶數,也可能為奇數,這樣便可以保證散列的均勻性,而如果length為奇數的話,很明顯length-1為偶數,它的最后一位是0,這樣h&(length-1)的最后一位肯定為0,即只能為偶數,這樣任何hash值都只會被散列到數組的偶數下標位置上,這便浪費了近一半的空間,因此,length取2的整數次冪,是為了使不同hash值發生碰撞的概率較小,這樣就能使元素在哈希表中均勻地散列。

?

這看上去很簡單,其實比較有玄機的,我們舉個例子來說明:

假設數組長度分別為15和16,優化后的hash碼分別為8和9,那么&運算后的結果如下:?

h & (table.length-1) hash table.length-18 & (15-1): 1000 & 1110 = 10009 & (15-1): 1001 & 1110 = 1000----------------------------------------------------------------------------------------8 & (16-1): 1000 & 1111 = 10009 & (16-1): 1001 & 1111 = 1001

從上面的例子中可以看出:當它們和15-1(1110)“與”的時候,產生了相同的結果,也就是說它們會定位到數組中的同一個位置上去,這就產生了碰撞,8和9會被放到數組中的同一個位置上形成鏈表,那么查詢的時候就需要遍歷這個鏈?表,得到8或者9,這樣就降低了查詢的效率。同時,我們也可以發現,當數組長度為15的時候,hash值會與15-1(1110)進行“與”,那么?最后一位永遠是0,而0001,0011,0101,1001,1011,0111,1101這幾個位置永遠都不能存放元素了,空間浪費相當大,更糟的是這種情況中,數組可以使用的位置比數組長度小了很多,這意味著進一步增加了碰撞的幾率,減慢了查詢的效率!而當數組長度為16時,即為2的n次方時,2n-1得到的二進制數的每個位上的值都為1,這使得在低位上&時,得到的和原hash的低位相同,加之hash(int?h)方法對key的hashCode的進一步優化,加入了高位計算,就使得只有相同的hash值的兩個值才會被放到數組中的同一個位置上形成鏈表。

?所以說,當數組長度為2的n次冪的時候,不同的key算得得index相同的幾率較小,那么數據在數組上分布就比較均勻,也就是說碰撞的幾率小,相對的,查詢的時候就不用遍歷某個位置上的鏈表,這樣查詢效率也就較高了。

? ? ? ?根據上面 put 方法的源代碼可以看出,當程序試圖將一個key-value對放入HashMap中時,程序首先根據該 key 的 hashCode() 返回值決定該 Entry 的存儲位置:如果兩個 Entry 的 key 的 hashCode() 返回值相同,那它們的存儲位置相同。如果這兩個 Entry 的 key 通過 equals 比較返回 true,新添加 Entry 的 value 將覆蓋集合中原有 Entry 的 value,但key不會覆蓋。如果這兩個 Entry 的 key 通過 equals 比較返回 false,新添加的 Entry 將與集合中原有 Entry 形成 Entry 鏈,而且新添加的 Entry 位于 Entry 鏈的頭部——具體說明繼續看 addEntry() 方法的說明。

1 void addEntry(int hash, K key, V value, int bucketIndex) { 2 Entry<K,V> e = table[bucketIndex]; //如果要加入的位置有值,將該位置原先的值設置為新entry的next,也就是新entry鏈表的下一個節點 3 table[bucketIndex] = new Entry<>(hash, key, value, e); 4 if (size++ >= threshold) //如果大于臨界值就擴容 5 resize(2 * table.length); //以2的倍數擴容 6 }

參數bucketIndex就是indexFor函數計算出來的索引值,第2行代碼是取得數組中索引為bucketIndex的Entry對象,第3行就是用hash、key、value構建一個新的Entry對象放到索引為bucketIndex的位置,并且將該位置原先的對象設置為新對象的next構成鏈表。

第4行和第5行就是判斷put后size是否達到了臨界值threshold,如果達到了臨界值就要進行擴容,HashMap擴容是擴為原來的兩倍。

resize()方法如下:

?重新調整HashMap的大小,newCapacity是調整后的單位

1 void resize(int newCapacity) {2 Entry[] oldTable = table;3 int oldCapacity = oldTable.length;4 if (oldCapacity == MAXIMUM_CAPACITY) {5 threshold = Integer.MAX_VALUE;6 return;7 }8 9 Entry[] newTable = new Entry[newCapacity]; 10 transfer(newTable);//用來將原先table的元素全部移到newTable里面 11 table = newTable; //再將newTable賦值給table 12 threshold = (int)(newCapacity * loadFactor);//重新計算臨界值 13 }

新建了一個HashMap的底層數組,上面代碼中第10行為調用transfer方法,將HashMap的全部元素添加到新的HashMap中,并重新計算元素在新的數組中的索引位置

transfer源碼解釋:

/*** Transfer all entries from current table to newTable.*/void transfer(Entry[] newTable) {Entry[] src = table;int newCapacity = newTable.length;for (int j = 0; j < src.length; j++) {Entry<K, V> e = src[j];if (e != null) {src[j] = null;do {Entry<K, V> next = e.next; //保存下一次循環的Entry //在新的table 中求得適合插入的位置int i = indexFor(e.hash, newCapacity);// 如果I位置原來沒有值,則直接插入;有值,采用鏈頭插入法e.next = newTable[i];newTable[i] = e;//輪替,下一次循環e = next;} while (e != null);}}}

當HashMap中的元素越來越多的時候,hash沖突的幾率也就越來越高,因為數組的長度是固定的。所以為了提高查詢的效率,就要對HashMap的數組進行擴容,數組擴容這個操作也會出現在ArrayList中,這是一個常用的操作,而在HashMap數組擴容之后,最消耗性能的點就出現了:原數組中的數據必須重新計算其在新數組中的位置,并放進去,這就是resize。

?? 那么HashMap什么時候進行擴容呢?當HashMap中的元素個數超過數組大小*loadFactor時,就會進行數組擴容,loadFactor的默認值為0.75,這是一個折中的取值。也就是說,默認情況下,數組大小為16,那么當HashMap中元素個數超過16*0.75=12的時候,就把數組的大小擴展為 2*16=32,即擴大一倍,然后重新計算每個元素在數組中的位置,擴容是需要進行數組復制的,復制數組是非常消耗性能的操作,所以如果我們已經預知HashMap中元素的個數,那么預設元素的個數能夠有效的提高HashMap的性能。

?5、數據讀取

public V get(Object key) { if (key == null) return getForNullKey(); int hash = hash(key.hashCode()); for (Entry<K,V> e = table[indexFor(hash, table.length)]; e != null; e = e.next) { Object k; if (e.hash == hash && ((k = e.key) == key || key.equals(k))) return e.value; } return null; }

有了上面存儲時的hash算法作為基礎,理解起來這段代碼就很容易了。從上面的源代碼中可以看出:從HashMap中get元素時,首先計算key的hashCode,找到數組中對應位置的某一元素,然后通過key的equals方法在對應位置的鏈表中找到需要的元素。

?

?? HashMap 包含如下幾個構造器:

?? HashMap():構建一個初始容量為 16,負載因子為 0.75 的 HashMap。

?? HashMap(int initialCapacity):構建一個初始容量為 initialCapacity,負載因子為 0.75 的 HashMap。

?? HashMap(int initialCapacity, float loadFactor):以指定初始容量、指定的負載因子創建一個 HashMap。

?? HashMap的基礎構造器HashMap(int initialCapacity, float loadFactor)帶有兩個參數,它們是初始容量initialCapacity和加載因子loadFactor。

?? initialCapacity:HashMap的最大容量,即為底層數組的長度。

?? loadFactor:負載因子loadFactor定義為:散列表的實際元素數目(n)/ 散列表的容量(m)。

?? 負載因子衡量的是一個散列表的空間的使用程度,負載因子越大表示散列表的裝填程度越高,反之愈小。對于使用鏈表法的散列表來說,查找一個元素的平均時間是O(1+a),因此如果負載因子越大,對空間的利用更充分,然而后果是查找效率的降低;如果負載因子太小,那么散列表的數據將過于稀疏,對空間造成嚴重浪費。

?? HashMap的實現中,通過threshold字段來判斷HashMap的最大容量:

?

threshold = (int)(capacity * loadFactor); 結合負載因子的定義公式可知,threshold就是在此loadFactor和capacity對應下允許的最大元素數目,超過這個數目就重新resize,以降低實際的負載因子。默認的的負載因子0.75是對空間和時間效率的一個平衡選擇。當容量超出此最大容量時, resize后的HashMap容量是容量的兩倍:

?

![[Ahoi2013]连通图](http://www.lydsy.com/JudgeOnline/upload/201306/1%283%29.jpg)